Una nueva era: inteligencia a coste casi cero

- Esteve Almirall

- BARCELONA. Jueves, 3 de octubre de 2024. 05:30

- Tiempo de lectura: 3 minutos

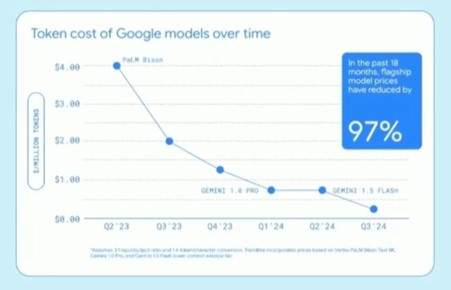

Hace pocos días, en una conferencia para estudiantes en Carnegie Mellon, Sundar Pichai compartió un dato sorprendente: el coste de los modelos de Google ha caído drásticamente en los últimos 18 meses. Hace un año y medio, procesar un millón de tokens costaba 4 dólares; hoy, ese mismo proceso cuesta solo 0,13 dólares, una reducción del 98%.

Si miramos los precios de OpenAI o Anthropic, observamos una tendencia similar. Esto no es exclusivo de Google, sino un reflejo de un fenómeno generalizado en el sector. Esta reducción en el coste es crucial, especialmente porque estas empresas están generando ingresos significativos con el uso de sus modelos por parte de otras organizaciones, y OpenAI y Anthropic son un claro ejemplo.

Este fenómeno está apenas comenzando. No hace tanto, Jensen Huang, el CEO de Nvidia, explicó cómo su empresa ha multiplicado por 1.000 la potencia de cómputo de sus procesadores en solo 8 años, superando con creces la Ley de Moore, que preveía un aumento de la potencia cada dos años. Además, Huang afirmó que aún hay margen para mantener este ritmo de mejora en el futuro inmediato, mientras presentaba la nueva familia de GPUs, Rubin.

Simultáneamente, vemos grandes avances en el campo del software. Hasta ahora, solo el lenguaje Julia se acercaba a las velocidades del C++, pero ahora también tenemos Mojo, una variación de Python que incluso supera al C++ en rendimiento.

Todo esto nos lleva a una conclusión evidente: el cómputo para tareas habituales que no implican I.A. generativa está a punto de alcanzar un coste prácticamente cero.

Muy pronto tendremos la capacidad de realizar tareas que consideramos inteligentes a un coste marginal prácticamente cero

Esta carrera desenfrenada, impulsada por la I.A. generativa, está transformando nuestros ordenadores, teléfonos y otros dispositivos en herramientas de cálculo con una potencia inimaginable hace solo unos años. Las grandes empresas tecnológicas son especialistas en computación masiva; ese es su negocio principal. Ganan poco por cada anuncio, pero pueden gestionar búsquedas masivas en la web o mantener en funcionamiento sistemas de comunicación globales como WhatsApp a un coste muy bajo. Nadie más lo hace a esta escala. Su objetivo ahora es lograr lo mismo con la I.A. generativa.

¿Lo lograrán? Cada día hay menos dudas, no solo sobre si lo harán, sino sobre cuándo lo harán. Su modelo de negocio se basa en sistemas altamente optimizados con costes marginales cercanos a cero.

En los últimos días también hemos visto la nueva generación de modelos de OpenAI, conocida como o-1, con varias variantes. Este modelo tiene un rendimiento comparable al de un estudiante de doctorado en campos como matemáticas, informática, genética, física, e incluso economía. Aunque no está entrenado en todos los campos, es una ventana hacia el futuro. Terence Tao, uno de los matemáticos más destacados del mundo, lo ha descrito como un estudiante de máster o doctorado mediocre en matemáticas, pero no totalmente incompetente, y prevé que en un par de iteraciones podría convertirse en un estudiante excelente. Un experto de JP Morgan, que participó en las primeras pruebas, señaló que este modelo es capaz de adaptar un contrato de cientos de páginas a los nuevos requisitos de cumplimiento normativo en cuestión de minutos, una tarea que para un experto legal podría requerir horas. El economista Tyler Cowen también ha puesto a prueba el modelo con preguntas propias de un doctorado en economía, obteniendo respuestas muy convincentes.

La carrera desenfrenada impulsada por la IA generativa está transformando nuestros ordenadores, teléfonos y otros dispositivos en herramientas de cálculo con una potencia inimaginable

La conclusión parece inevitable: muy pronto tendremos la capacidad de realizar tareas que consideramos inteligentes a un coste marginal prácticamente cero.

No solo eso, hace unos días (6-9-24) se publicó un artículo de Si, Yang y Hashimoto, de la Universidad de Stanford, titulado "Can LLMs Generate Novel Research Ideas?", donde se comparaban las ideas de investigación generadas por grandes modelos de lenguaje (LLMs) con las de los académicos. Sorprendentemente, las ideas de los LLMs resultaron ser superiores.

A todo esto se suma la caída en el coste de la energía gracias al auge de la computación y a los vehículos eléctricos, impulsados por la instalación masiva de energía solar y microcentrales nucleares en China. Esto hace que en algunos días el coste de la energía sea incluso negativo.

Así, la humanidad se enfrenta a un nuevo escenario: energía e “inteligencia” a un coste cercano a cero. Pero cómo se distribuirán estos beneficios, y a quién llegarán, será una cuestión política. Al final, solo los países con soberanía tecnológica tendrán la capacidad de elegir; los dependientes no tendrán esa opción.