Després de la decisió presa per la Comissió Europea (CE) de vetar l'ús indiscriminat dels sistemes d'intel·ligència artificial (IA) denominats d'"alt risc", com ara el reconeixement facial, els experts en la matèria corroboren que aquestes tecnologies poden atemptar contra els drets dels ciutadans.

El 21 d'abril passat, la CE va aprovar un reglament que regula quan està permès l'ús de tecnologies intel·ligents com el reconeixement facial. Segons la CE, la vigilància massiva de persones només està permesa en determinades circumstàncies, com ara la cerca d'un nen desaparegut o d'un criminal sospitós d'un delicte molt greu.

A més, la vigilància massiva sempre haurà d'estar aprovada per un jutge i utilitzada només en situacions on sigui estrictament necessària per respondre a un risc específic i imminent, i mai com a rutina. Per tant, la CE estudia maneres d'utilitzar aquesta nova tecnologia de manera respectuosa amb les llibertats personals dels ciutadans, com ara el dret a la vida privada.

Segons la directora de l'Agència Espanyola de Protecció de Dades, Mar España, aquest nou reglament permetrà crear un "entorn tecnològic sostenible a llarg termini" en relació amb la IA, tal com ha dit en declaracions a Efe.

Equilibri entre seguretat i llibertat

Per elaborar l'estudi dels avantatges i perills de la IA, els europeus parteixen de precedents com el de la Xina, on el govern utilitza la vigilància massiva per controlar i puntuar els ciutadans segons el seu comportament, i motoritzar els seus moviments. A Londres, la policia també utilitza aquesta tecnologia per combatre el crim.

Dins la UE, la preocupació per l'equilibri entre la seguretat i la llibertat dels ciutadans ha portat a la regulació de l'ús de dades per a fins lucratius en l'àmbit europeu mitjançant el Reglament General de Protecció de Dades (RGPD). A l'Estat espanyol, l'Agència de Protecció de Dades ja va alertar, a través d'un informe, dels riscos dels sistemes de reconeixement facial pels drets fonamentals de les persones, a més de les "greus conseqüències" per als ciutadans si la tecnologia biomètrica s'equivoca.

El principal problema és que la IA només és tan objectiva, eficient o fiable com el seu creador. És a dir, es pot basar en estereotips de raça o classe per jutjar i identificar els potencials criminals, de la mateixa manera que ho fan els humans.

El reglament vigent

De moment, el reglament adoptat per la UE classifica les diferents tecnologies amb IA segons el seu grau de 'perillositat', fet que comporta el primer pas per definir un marc legal conjunt en l'àmbit europeu. Els riscs estan dividits així: 'risc inacceptable' que estan totalment prohibides (per exemple, joguines que encoratgen conductes perilloses a menors o sistemes que puntuen als ciutadans); 'alt risc', que interfereixen greument amb els drets fonamentals de les persones i que seran regulades molt estrictament (per exemple, IA que avaluï la veracitat de les proves criminals); 'risc limitat', que hauran de garantir la seva transparència (per exemple, l'ús de bots d'ajuda); 'risc mínim', que no serà intervingut per la llei reguladora (per exemple la IA als videojocs).

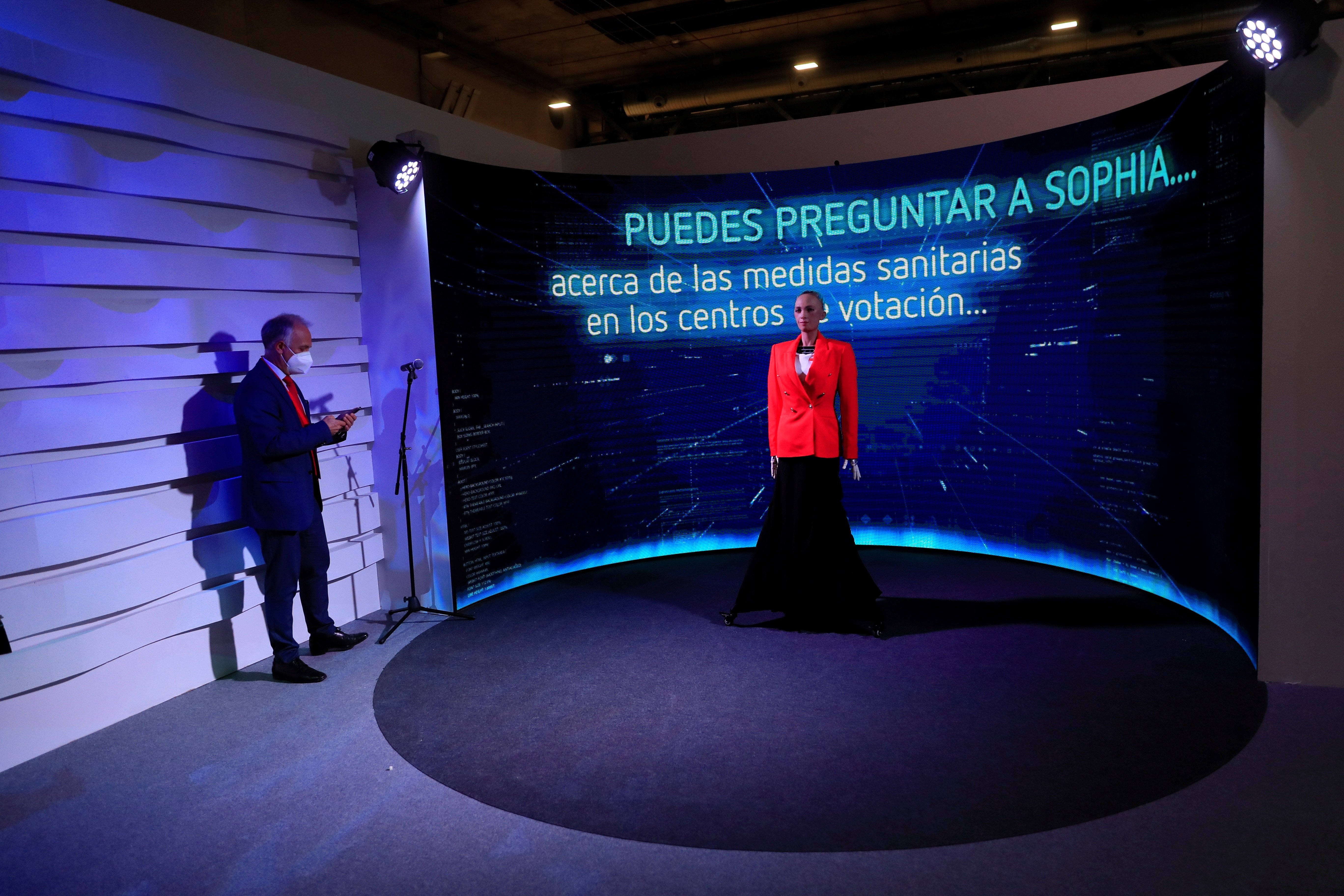

Foto principal: el robot humanitzat 'Sofia' explica les mesures de seguretat anti-Covid per les eleccions de la Comunitat de Madrid / Efe